1.1 方案简介

方案需求

某用户需要一套雷达的数据处理的解决方案,该数据处理算法复杂,数据量大,并需要在指定脉冲周期内实时完成数据处理,实时性要求非常高,而且需要在嵌入式环境中构建高性能计算系统,因此希望在尽量小体积、低功耗条件下,实现尽可能强的计算能力。HPEC(High-Performance Embedded Computer)系统是这需求中的理想解决方案。

抗震性:普通高性能集群在飞机,航舰,车辆等震荡环境中受到了限制,HPEC系统的机箱背板互联方式使系统抗震性更强。

高密度:在机载等移动环境中,高密度可以保证在更小体积下提供更高计算能力,节省空间。

低功耗:不止绿色节能,降低运作成本,更重要的是解决了特殊环境中供电受限的问题。

实时性:完成高性能计算,实时处理分析海量现场数据。

可扩展性:在设计上充分考虑到可扩展性需求,提供具有最高可伸缩性的系统,并保护用户现有的投资。

稳定性:整体系统确保稳定、高效、连续地运营,能够支持全天24 小时的连续运行需求。

方案架构

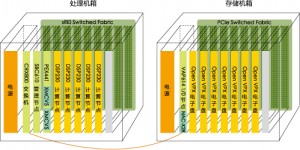

相对大规模的计算集群来讲,HPEC系统体积比较小,集成度高,所有部分全集成在机箱内部。HPEC系统计划采用VPX规格机箱,高性能嵌入式计算机,控制主板,Switch板做成VPX规格板卡,如图1-6所示。

图 1-6

1.2 节点系统

大型HPC系统和嵌入式HPEC系统相比,主要功能部分大同小异,对比如下:

功能模块 大型HPC系统 嵌入式HPC系统

计算 计算集群 嵌入式高性能计算机

管理 管理节点集群 嵌入式控制主板

Switch 高速交换机 交换板

存储 存储节点+存储阵列 电子盘

连接 InfiniBand线缆或网线 背板连接

机箱:2个6U的VPX规格机箱,分别为处理机箱和存储机箱。

管理节点:1块SBC610单板计算机, 双核处理,内置RapidIO串行接口和千兆以太网接口,用于状态运行分析、作业调度和集群部署。

计算节点1:2块XMCV5型号FPGA协处理器做数据预处理,通过PEX441载卡于 sRIO背板连接。

计算节点2:5块DSP230处理器板,每块均内置4个双核处理器,以最小的体积和功耗来达到最大的计算能力。

I/O节点:1块VAP614单板计算机,用于管理电子盘,内置NAC-X2R卡,完成 PCIe-sRIO的转换。

交换机:1台CRX800 型号RapidIO交换板,用于处理机箱内板卡的SRIO通信。

1.3 网络系统

互联协议趋势本方案中, 本系统配置3个网络,包括:

板间sRIO互联

本方案的处理机箱内采用sRIO互联方式。sRIO是面向嵌入式系统开发提出的高可靠、高性能、基于包交换的新一代高速互联技术,支持1.25 Gbps、2.5 Gbps、3.125 Gbps、5 Gbps、6.25 Gbps五种速度,能满足不同应用需求,支持复杂的可扩展拓扑,多点传输;未来十几年中嵌入式系统互联的最佳选择之一。

板间PCIe互联

本方案的存储机箱内采用PCIe互联方式。PCIe在现在的嵌入式产品中使用的很广泛。包含三个版本PCIe 1.0,PCIe 2.0,PCIe 3.0,传输速度分别对应为2.5Gbps、5Gbps,8Gbps。PCIe 3.0是现阶段比较新的总线和接口标准,它和PCIe 2.0相比,数据吞吐量有显著的增加。同时还特别增加了128b/130b解码机制,可以确保几乎100%的传输效率,相比此前版本的8b/10b机制提升了25%,从而促成了传输带宽的翻番,延续了PCIe规范的一贯传统。

板外互联

本方案处理机箱与存储机箱之间连接采用的sRIO连接。具体连接方式是从处理机箱的CRX800交换板连接到存储机箱的VAP614主板的NAC-X2R转换卡上。

1.4 存储系统

目前的主流存储硬盘功耗非常大,占用空间也非常的大,抗震性能不好,工作温度范围窄,而且IOPS性能相当差。而固态电子盘速度远远超过了机械盘的读写速度。同时PCIe接口开始应用于固态电子盘中,从而更大的提高的固态硬盘的技术,现在主流的PCIe的速度可以达到550MB/s,未来,PCIe的读写速度甚至可以达到1GB/s,成为目前最快的存储访问接口。随工艺提高,固态电子盘的成本开始慢慢下降。随着时间的推移,电子盘取代机械硬盘成为存储技术的主流存储介质将是历史的必然发展规律。

1.5 管理软件

嵌入式集群管理系统可以对整个系统进行统一管理,主要实现的功能包括:

显示所有板卡的BIT自检测结果,验证硬件是否正常运作。

监控识别和诊断缺陷应用程序。

通过Telnet连接到已定义的节点,用控制台进行分别控制或统一控制。

自动识别网络链路。

记录并显示各个组件的性能属性温度、CPU使用率等。

负载均衡控制

作业管理

历史数据回溯